Chatbot Arena: đấu trường các Chatbot cạnh tranh thứ hạng với nhau

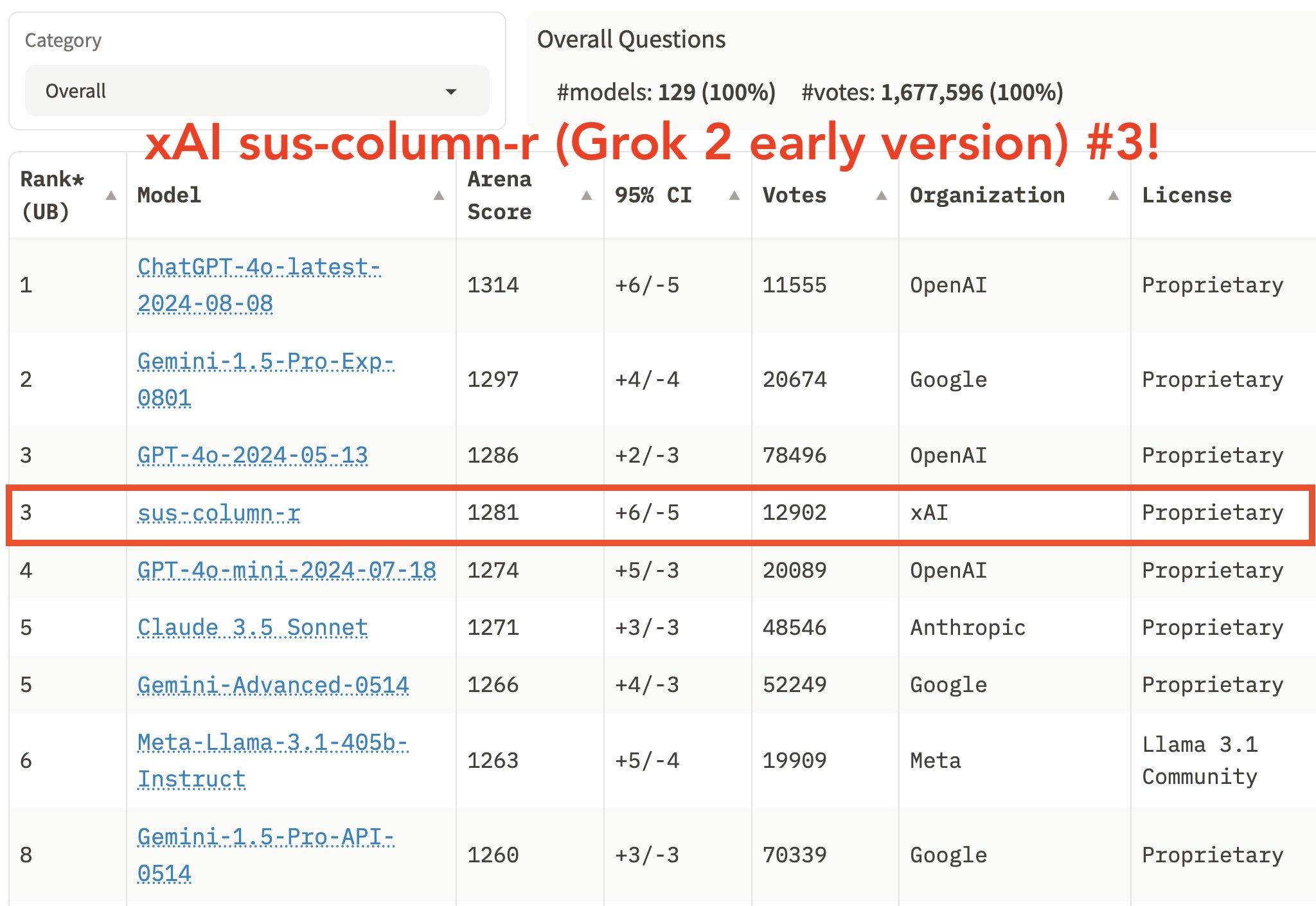

Nếu bạn thường theo dõi Elon Musk, bạn có thể thấy ông thỉnh thoảng đăng về Grok AI và vị trí của nó trên bảng xếp hạng. Các đối thủ của Grok bao gồm nhiều mô hình nổi tiếng như Gemini, GPT, Claude, và nhiều mô hình khác. Vậy Chatbot Arena là gì mà khiến các mô hình hàng đầu này cạnh tranh từng chút một để leo lên thứ hạng cao hơn? Bài viết này sẽ giới thiệu cách các mô hình AI được đánh giá và tối ưu hóa.

LMSYS và Chatbot Arena

LMSYS là tổ chức vận hành Chatbot Arena. Ban đầu, dự án này được các sinh viên từ Carnegie Mellon, SkyLab của Berkeley, và UC San Diego khởi xướng. Hiện tại, LMSYS được vận hành bởi các nhà nghiên cứu tại SkyLab. Mục tiêu ban đầu là sử dụng các mô hình nguồn mở và tối ưu hóa chúng. Tuy nhiên, trong quá trình làm việc, nhóm nghiên cứu nhận ra các công cụ đánh giá các mô hình LLM hiện nay phần lớn là dựa trên một tập dữ liệu đã có sẵn. Điều này đặt ra một câu hỏi rằng liệu góc nhìn của người dùng ở đâu khi đánh giá các mô hình AI. Chatbot Arena ra đời để tìm cách trả lời cho câu hỏi đó khi nó được phát triển để trở thành một hệ thống đánh giá thực tế, với các mô hình được so sánh dựa trên phản hồi từ người dùng.

Chatbot Arena được vận hành bởi LMSYS để đánh giá các mô hình AI

Phương pháp đánh giá một mô hình AI

Việc đánh giá hiệu suất của một mô hình AI thường dựa vào các tập dữ liệu định nghĩa sẵn, có thể là tĩnh hoặc động tùy theo mục tiêu của việc đánh giá.

Đánh giá dựa trên tập dữ liệu tĩnh

Với các tập dữ liệu tĩnh, nó được sử dụng để kiểm tra khả năng của các mô hình AI trong việc thực hiện các nhiệm vụ được xác định trước. Các tập dữ liệu này không được thay đổi, cập nhật theo thời gian. Điều này có nghĩa là mỗi mô hình được đánh giá dựa trên cùng một tập dữ liệu, câu hỏi, vấn đề. Cách tiếp cận này sẽ tạo ra một môi trường được kiểm soát nhưng hiệu quả đánh giá bị giới hạn khi nó không cho phép việc kiểm tra khả năng thích nghi với những bài toán khó hơn hoặc những cách khác nhau mà người dùng cung cấp thông tin.

Phương thức này sử dụng một số tập dữ liệu phổ biến như:

- GLUE (General Language Understand Evaluation): Đo lường khả năng hiểu và xử lý ngôn ngữ tự nhiên, chẳng hạn như phân tích cảm xúc hoặc xác định tính chính xác ngữ pháp. Ví dụ, benchmark này có thể thực hiện được việc xác định hai câu nói: “The cat is sleeping on the mat.” và “Sleeping cat the on is mat.” đúng hay sai cấu trúc ngữ pháp.

- SuperGlue: là mô hình nâng cấp từ GLUE kiểm tra khả năng tư duy, lý luận của mô hình qua nhiều bước.

- MMLU (Massive Multitask Language Understanding): là cách đánh giá mô hình AI trên nhiều lĩnh vực khác nhau như toán, hoá học, vật lý, lịch sử. Tuy nhiên, mô hình này chỉ dừng lại ở việc kiểm tra cách các mô hinh AI trả lời các thông tin chứ không kiểm tra được cách nó hoạt động với các tác vụ, câu hỏi mở.

- SQuAD (Stanford Question Answering Dataset) mô hình đo lường khá nổi tiếng, ánh giá khả năng trả lời câu hỏi dựa trên văn bản. Mỗi mô hình được kiểm tra dựa trên một tập câu hỏi và đáp án. Ví dụ như khi được hỏi “Ai là người tạo ra thuyết tương đối”, mô hình sẽ được đánh giá là hoạt động đúng nếu câu trả lời là “Albert Einstein”.

Những hệ thống đo lường kể trên làm rất tốt việc kiểm tra mô hình AI với khả năng thực hiện các tác vụ đơn giản về ngôn ngữ, hay trả lời những câu hỏi mang tính chất tra cứu thông tin nhưng trên thực tế, phổ sử dụng của người dùng sẽ trải dài với rất nhiều nhu cầu: tương tác, viết email, bày tỏ cảm xúc, thực hiện các tác vụ đòi hỏi tư duy. Với các tác vụ này, những phương pháp kể trên hoàn toàn không có khả năng đánh giá liệu các mô hình có thực hiện tốt hay không.

Ngoài ra, việc một mô hình được đánh giá bởi cùng một tập dữ liệu theo thời gian có rủi ro dẫn tới việc nó “học thuộc lòng” những thông tin có được từ tập dữ liệu đó để hoàn thành xuất sắc những tác vụ liên quan. Điều này sẽ làm sai lệch quá trình đánh giá vì nó không phản ánh được hiệu năng thật sự của mô hình đó.

Đánh giá dựa trên tập dữ liệu động

Ngoài tập dữ liệu tĩnh, các mô hình AI cũng được đánh giá qua tập dữ liệu động, tức là liên tục được cập nhật và thay đổi theo thời gian. Dynabench là một ví dụ điển hình, nơi các dữ liệu mới và nhiệm vụ thách thức hơn được thêm vào thường xuyên, buộc mô hình phải thích ứng với các tình huống thực tế hơn.

Ưu điểm của phương pháp này là khuyến khích mô hình AI tổng quát hóa tốt hơn, dựa trên dữ liệu mới thay vì chỉ tập trung vào các bài toán cố định. Nó cũng giải quyết vấn đề các mô hình chỉ “học thuộc” thông tin và cung cấp một đánh giá chính xác hơn về hiệu năng thực tế.

Chatbot Arena và tập dữ liệu từ đánh giá người dùng

Tuy nhiên, điểm trừ lớn nhất của các thang đo kể trên là chúng không lấy phản hồi của người dùng về câu trả lời mà các mô hình LLM cung cấp. Chatbot Arena sẽ giải quyết vấn đề này qua việc lấy ý kiến người dùng. Đầu tiên, nhóm nghiên cứu tạo ra tập dữ liệu LMSYS-Chat-1M, bao gồm một triệu cuộc hội thoại giữa người dùng và 25 mô hình LLM hỗ trợ ban đầu. Các cuộc hội thoại này trải dài trên hơn 100 ngôn ngữ, như tiếng Anh, Pháp, Trung, Nga, Tây Ban Nha, Đức, v.v.

Sau đó, khi hệ thống chưa có được những thông tin đánh giá, Chatbot Arena sẽ lấy thông tin từ các chuyên gia, các mô hình benchmark kể trên, tập dữ liệu mà nhóm phát triển LMSYS-Chat-1M hay việc để các mô hình LLM tự đánh giá lẫn nhau để đưa ra những thứ bậc cơ bản.

Sau đó, khi người dùng đưa ra sự lựa chọn của mình khi được yêu cầu đánh giá câu trả lời từ hai mô hình ẩn danh, lựa chọn đó sẽ được bổ sung vào tập dữ liệu động mà nhóm nghiên cứu thu thập. Theo thời gian, các lựa chọn đó sẽ tích luỹ dần và cung cấp một phản hồi về liệu mô hình này đang hoạt động tốt hơn so với mô hình khác trong các tác vụ thực tế. Với dữ liệu này, nhóm nghiên cứu sẽ thực hiện việc phân tích xác suất thống kê để cập nhật thứ bậc dựa trên các cặp được sử dụng để so sánh. Các cặp tiếp theo để người đùng đánh giá sẽ là các cặp được xác định là cần thêm dữ liệu để thứ hạng của nó được phản ánh chính xác hơn.

Kết quả đầu ra là việc thứ bậc của mô hình được cập nhật và nó sẽ được phản ảnh trên bảng xếp hạng mà Chatbot Arena cung cấp. Lựa chọn một người dùng tuy nhỏ, nhưng theo thời gian, khi nhiều người dùng đóng góp thì nó sẽ có sự tác động rất lớn tới kết quả xếp hạng. Và quá trình này được lặp đi lặp lại để đảm bảo các mô hình được đánh giá một cách khách quan nhất. LMSYS thu thập khoảng 8000 lựa chọn cho mỗi mô hình trước khi nó cập nhật thứ hạng, và thường thì chỉ vài ngày là cột mốc này được chinh phục để có sự thay đổi trên Chatbot Arena.

Từ khi Chatbot Arena ra đời. LMSYS đã thêm vào nhiều mô hình để đo lường với số lượng hiện tại là 100 mô hình. LMSYS cũng hợp tác với các trường đại học, các công ty như OpenAI, Google, Anthropic, Microsoft, Meta, Mistral and Hugging Face để đảm bảo các mô hình của các ông lớn này được sử dụng để kiểm tra. Ngoài ra, hàng triệu prOmpt và cặp so sánh đã được thực hiện bằng cách này tạo ra một tập dữ liệu xếp hạng khổng lồ.

Quan ngại với Chatbot Arena

Dù cải tiến hơn so với các mô hình đánh giá cũ, Chatbot Arena vẫn đối mặt với một số câu hỏi từ cộng đồng AI. Một mối lo ngại là liệu các câu hỏi từ người dùng có đủ đa dạng để đánh giá toàn diện các khả năng của mô hình AI. LMSYS cũng không tiết lộ nhiều chi tiết về cách dữ liệu được sử dụng để đánh giá.

Ngoài ra, cách lấy ý kiến người dùng như Chatbot Arena làm không đảm bảo tất cả các lựa chọn đều phản ánh đúng chất lượng câu trả lời. Người dùng có thể không đủ lý trí khi đưa ra lựa chọn, có sự thiên vị hay không xác định được liệu mô hình AI có đang bị ảo giác hay không. Ví dụ như một số người vì thích cách trả lời ngắn gọn, hay phong cách hiển thị mark down mà lựa chọn câu trả lời đó thay vì tính xác thực mà thông tin nó mang lại.

Một vấn đề nữa là có những công ty đang cố gắng tối ưu hóa mô hình của họ để thích ứng với cách Chatbot Arena đo lường, thay vì tối ưu hóa vì lợi ích thực sự của người dùng. Điều này, cộng với sự tham gia của các “ông lớn” như Google, Mistral, cũng đặt ra câu hỏi về tính khách quan của quá trình đánh giá.

Tin xem thêm

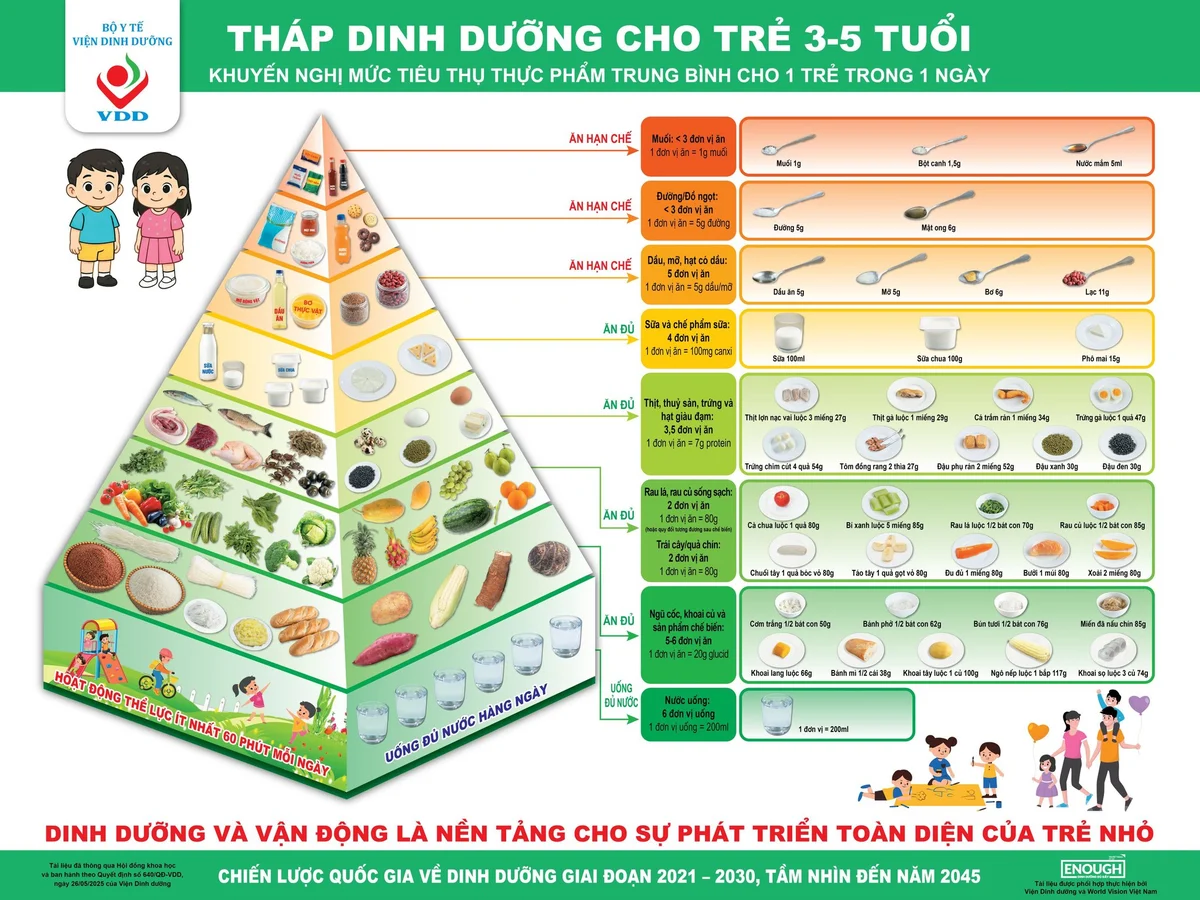

Bộ Y tế cho ra mắt Cổng thông tin Dinh dưỡng trên mạng

Bộ Y tế cho ra mắt Cổng thông tin Dinh dưỡng trên mạng

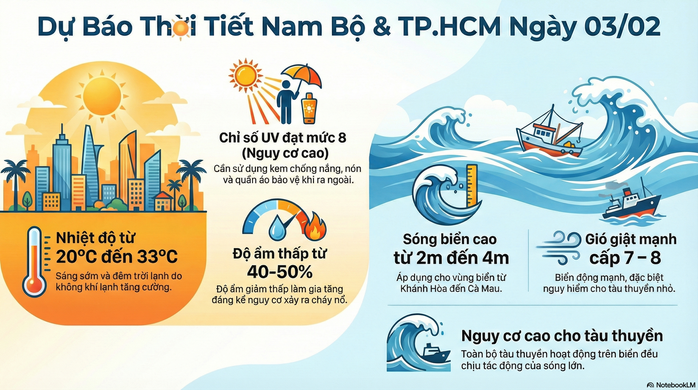

Dự báo thời tiết hôm nay, 3-2: TPHCM và Nam Bộ nắng mạnh, cảnh báo tia UV

Theo dự báo thời tiết hôm nay, TPHCM và Nam Bộ tiếp tục duy trì hình thái đặc trưng mùa khô, ngày nắng với độ ẩm thấp, chỉ số UV cao.

Mời anh em thẩm: Xuất hiện ảnh quảng cáo của Samsung Galaxy S26 Ultra?

Xuất hiện ảnh quảng cáo của Samsung Galaxy S26 Ultra?

Honda CR-V e:HEV lắp ráp tại Việt Nam chính thức ra mắt với một số nâng cấp

Phiên bản Hybrid của Honda CR-V đã được chuyển sang lắp ráp trong nước với một số bổ sung nhẹ về mặt trang bị tiện nghi trong khoang lái. Honda CR-V e:HEV 2026 mang đến h...

Giá vé máy bay 'leo thang' dịp Tết Bính Ngọ, lựa chọn nào cho hành trình về quê?

Cận Tết Nguyên đán Bính Ngọ 2026, giá vé máy bay trên nhiều đường bay nội địa tăng cao, đặc biệt là ở các chặng từ TP.HCM, Hà Nội đi các tỉnh.

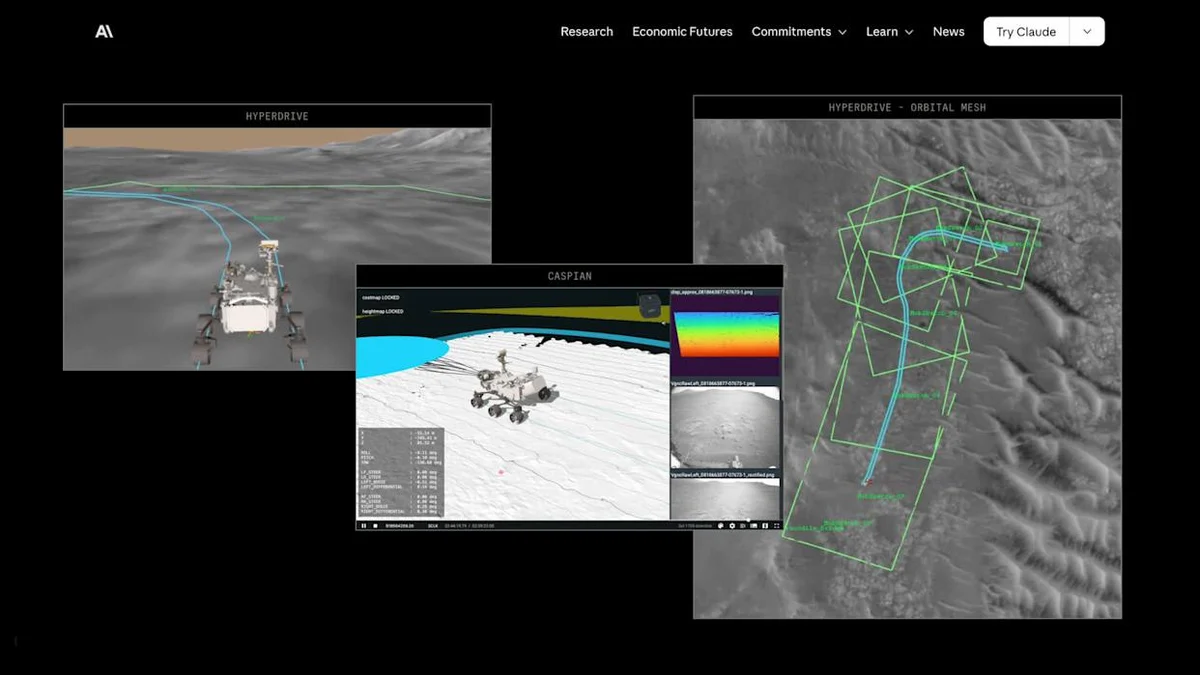

NASA đưa AI lên tới sao Hoả rồi anh em nha!

NASA đưa AI lên tới sao Hoả rồi

OpenAI sẽ “dọn dẹp” danh sách model trong ChatGPT

OpenAI sẽ “dọn dẹp” danh sách model trong ChatGPT

Xóa bỏ định kiến “mùa vụ”, thúc đẩy du lịch Hương Sơn đón khách cả 4 mùa

Với định hướng phát triển công nghiệp văn hóa giai đoạn 2025 - 2030, cùng với đó là việc tiến tới xây dựng Khu di tích quốc gia đặc biệt chùa Hương trở thành khu du lịch ...

Ah em VIP chú ý: Leica Noctilux M 35mm f/1.2 ASPH chính thức giá mắt, giá €8,950

Leica Noctilux M 35mm f/1.2 ASPH chính thức giá mắt, giá €8,950

nội dung mới